Elindult az Indamedia média és marketing-kommunikációs kiadványa.

További szakmai tartalmakért kattints és kövess bennünket!

MEGNÉZEM

Az elmúlt időszakban az internet a korábbinál is sokkal fontosabb erőforrássá vált, a járvány alatt több millióan tulajdonképpen csak itt tartották a kapcsolatot a külvilággal, ez pedig a különféle online kommunikációs platformok robbanásszerű növekedéséhez vezetett. Bizonyos tekintetben úgy is fel lehet fogni a dolgot, hogy végre tényleg azzá a globális, közösségformáló erőforrássá vált, aminek a megszületésekor tervezték, ám a különféle közösségi platformok helyzetéből ítélve ez továbbra is inkább tűnik vágyálomnak, mint valóságnak.

Az elmúlt években a piacvezető felületeket, így a Facebookot is sokan támadták azért, mert nem tesznek eleget az álhírek, összeesküvés-elméletek, dezinformációs kampányok és a gyűlöletbeszéd visszaszorításáért. A cég az idők során rengeteget fejlődött az ilyen tartalmak kiszűrése terén, nemrég pedig minden eddiginél nagyobb lépést tett a transzparencia irányába azzal, hogy létrehoztak egy, a cégtől független felügyelőtanácsot, ami a vitás kérdésekben dönthet. A jelenlegi helyzetben ugyanakkor

a többi platformhoz hasonlóan a Facebook sem feltétlenül a javulás irányába mozdult el.

Ez persze érthető is, a megnövekedett felhasználói aktivitás miatt sokkal fontosabbá vált az esetleges biztonsági rések betömködése, de ennél is nagyobb problémát jelentett az alapesetben is rendkívül nehéz moderáció kérdése. A kialakult helyzetben a vitás tartalmak mennyiségének növekedése mellett csökkent a moderátorok száma, így a folyamatba egyre inkább bevonták a mesterséges intelligenciát, ami csak tovább komplikálta az egyébként is rendkívül bonyolult egyenletet.

A koronavírus-járvány miatt bevezetett korlátozások egyik legfontosabb hozománya volt az alkalmazottak hazaküldése, amit sok cég elég jól vészelt át, a Facebook esetében azonban ennek tényleg érezhetőek voltak a negatív következményei. Az intézkedés értelmében a cég által alkalmazott moderátorok többsége sem mehetett be az irodákba, az ő esetükben azonban a távmunka többnyire ki volt zárva. A cég magyarázata szerin ennek több oka volt, többek közt például az, hogy

Emberi moderátorok természetesen így is maradtak, a Facebook azonban más nagy internetes platformokhoz hasonlóan kénytelen volt még az eddiginél is sokkal jobban támaszkodni a mesterséges intelligenciára – dacára annak, hogy a technológia egyértelműen nem áll még készen az ilyen mértékű használatra, és ők maguk is beismerték, hogy hibákhoz vezethet majd a dolog. Ugyan a mesterséges intelligencia és a gépi tanulásos módszerek papíron tökéletes eszköznek tűnnek a káros tartalmak kiszűréséhez, jelenlegi formájukban inkább olyanok, mintha furkósbottal próbálnánk meg felhőkarcolót építeni.

Egy számítógép egy sor dolgot képes megállapítani egy bejegyzésről, meg tudja mondani, hogy hányan látták, honnan tették közzé, kik osztották meg, hányszor jelentették, megegyezik-e bármilyen korábbi, már szabályzatba ütközőnek minősített tartalommal és így tovább. Az adott bejegyzést ugyanakkor nem képes értelmezni, és önállóan megalapozott döntést sem tud hozni, így pedig egy ilyen algoritmus bizonyos kontextusban hajlamos túlszabályozni, más, esetleg valóban problémás tartalmak fölött viszont elsiklik.

Ugyan a cég feszített tempóban próbálta visszaszorítani a koronavírusos álhíreket, az automatizmusok csak mérsékelt sikert értek el a hajmeresztő hülyeségek kiszűrésében, miközben az irányelveket nem sértő, sőt, esetenként hasznos tartalmakat távolítottak el – ilyen volt például az, amikor az algoritmus tiltással fenyegette a házilag készített arcmaszkokról készült képeket feltöltőket, mert nyerészkedésnek nézte a posztokat. De hogy egy friss példát is hozzunk, az is látványos mellélövés volt, amikor napokig tiltotta azokat a felhasználókat, akik megosztották a Guardian egyik cikkét, mert úgy ítélte meg, hogy az illusztrációként használt képen meztelenek a megláncolt ausztrál bennszülöttek. Ez az eset egyébként eléggé hasonlít arra, amikor a Facebook cenzúrázta a világ leghíresebb háborús fotóját, mert azt hitte róla, hogy gyerekpornó.

Az ilyen hibák nem pusztán azért kínosak, mert kellemetlenséget okoznak a felhasználóknak, bizonyos esetekben elég károsak is lehetnek. Azok a moderációs irányelvek, amelyek jól működnek nyugaton, nem feltétlenül alkalmazhatóak a világ minden pontján, ahogy a helyi törvényekkel sem mindig feltétlenül jó harmóniában működni.

Erre jó példa az, hogy 2010-ben a Facebook törölte azt az egyiptomi oldalt, aminek később kulcsszerepe volt az arab tavasz kirobbantásában, mert az azt üzemeltetők nem a valódi nevükkel voltak jelen a platformon, később pedig gyakran tiltották le az ott zajló eseményeket dokumentáló posztokat, mert azok megsértették a platform irányelveit. Ebből is látszik, hogy a hibásan eltávolított tartalmak vagy a lassú reagálás egyértelműen jobban érintik a harmadik világ (vagy ahogy politikailag korrektebben szokás hívni őket, a globális dél) országait, illetve azokat a felhasználókat, akik kevésbé támogatott nyelveket beszélnek, pedig itt sokszor az emberi jogok komoly csorbulásáról van szó.

Hasonlóan nagy probléma az is, hogy a hibásan eltávolított tartalmak és törölt fiókok esetében fellebbezni ugyan lehet, ám nagyon gyakori az, hogy

a felhasználó nem kap megfelelő magyarázatot arra, hogy miért született ellene döntés.

Az eltávolított posztokat sokszor megnézni sem lehet, és az is előfordul, hogy fellebbezés helyett az ember csak arra kap lehetőséget, hogy elmondja a véleményét a döntésről, ennek azonban

deklaráltan semmilyen következménye nincsen azon túl, hogy elméletileg segíti a Facebookot a későbbi döntések meghozatalában.

Mindez a járvánnyal csak rosszabbodott, de már előtte sem volt túl jó a helyzet, a kontextus figyelembe vétele ugyanis meglehetősen kemény dió. Egyértelmű például, hogy nem lehet a világ minden táján az Egyesült Államokban elfogadott normák alapján moderálni – míg például Amerikában a negro a feketékre nézve pejoratív felhangokkal bír, spanyol és portugál nyelvterületen ezt a szót használják arra, hogy fekete. A memék esetében is elég érdekes a helyzet, az algoritmusok ugyanis egyszerűen nem képesek arra, hogy különbséget tegyenek az irónia és a komoly bejegyzések között, így például valószínűleg sosem fogják tudni megállapítani, hogy egy képen a "remélem, valaki lelő" mondat valóban szuicid gondolatokra utal, vagy csak akasztófahumorról van szó (attól most tekintsünk el, hogy ez vicces-e vagy sem).

Arról, hogy pontosan miként moderálják a szatirikus posztokat és a meméket, megkérdeztük a Facebook sajtóirodáját is, ami kérdésünkre azt válaszolta, hogy

A meglehetősen általános válaszból sok konkrétumot nem lehet kihámozni, de visszakanyarodva a korábbi példához,

saját tapasztalataim alapján ennyire nem mindig gördülékeny a dolog.

A Facebookon jó ideje létezik már protokoll az öngyilkosságot vagy önkárosítást sejtető tartalmak kezelésére, amivel az illető segítséget kérhet különböző szervezetektől vagy a saját ismerőseitől. Ez a felület általában akkor ugrik fel valakinek, ha egy ismerőse – vagy bárki, aki láthatta a posztot – a megfelelő módon jelentett egy ilyen bejegyzést. Az oldal moderációs irányelvei alapján az ilyen posztokat csak akkor törlik, ha szakértői vélemények alapján másokat is hasonló viselkedésre sarkallhatnak, éppen azért, hogy biztosan segítséget kaphasson az illető.

Azt nem lehet tudni, hogy pontosan mit mérlegelnek itt, de érzésre a gyakorlatban azért ez nem mindig történik így, vagy legalábbis az én olvasatomban a fent idézett mondat ("remélem, valaki lelő") sem önmagában, sem kontextusában nem alkalmas arra, hogy bárkit bármire sarkalljon. Ennek a megítélése lehet szubjektív, egy dolgot azonban mindenképpen ki kell emelni: ha károsnak ítélik a bejegyzést, akkor az első alkalom után nem pusztán törlik, de valamennyi időre le is tiltják a felhasználót, aki így sem posztolni, sem reagálni, sem üzenetet küldeni nem tud – akár viccelt, akár nem.

Hasonlóan bizarr az is, hogy idén több alkalommal távolították már el olyan bejegyzésemet, amelyben az említés szintjén szerepelt valamilyen drog, az algoritmus pedig egy alkalommal online zaklatásnak vett egy olyan képet, amelyben egy szájában kardot tartó doge fölött a hírhedt Navy Seal Copypasta első sora szerepelt. Persze nyilvánvaló, hogy nem várható el a moderátoroktól, hogy ismerjék az összes létező memét, de még ha el is tekintünk attól, hogy egy elég közismert szövegről van szó, viszonylag abszurdnak tűnik az, hogy a "What the fuck did you just fucking say about me, you little bitch?", vagyis magyarul nagyjából "Mi a faszt mondtál rólam, te kis ribanc?" mondat miatt töröljenek egy posztot, miközben nagyjából ugyanez körülbelül minden második internetes vitában elhangzik.

Mindezzel azonban nem is lenne baj: ha a Facebook konzekvensen törölne minden rizikósabb tartalmat, azzal együtt lehetne élni. A cég kommunikációja és a moderáció gyakorlata azonban sok tekintetben nagyon messze van a következetességtől. Erre remek példa az, hogy két éve Mark Zuckerberg cégvezér, tavaly pedig Joel Kaplan, a cég globális irányelveiért felelős igazgató-helyettes szögezte le azt, hogy nem távolítják el a hazugságot vagy téves információkat tartalmazó posztokat – legyen az a holokauszt vagy az örmény népirtás tagadása –, mert

hisznek abban, hogy a Facebookon mindenkinek joga van téves vagy pontatlan dolgokat megosztani, még akkor is, ha az offenzív.

A cég nagyjából ezen a vonalon maradva nem törölte Donald Trump posztjait sem, dacára annak, hogy több konkurense is így tett, a dolgozóik sztrájkoltak is emiatt, és több kutató is arra kérte Zuckerberget, hogy tartsa féken a gyűlöletet az oldalon. Egy hónappal később aztán végül a cég beadta a derekát, és bejelentette, hogy a Twitterhez hasonlóan a jövőben jelölni fogja a szabályzatát sértő hírértékű tartalmakat, szükség esetén pedig az amerikai elnökválasztással kapcsolatos bejegyzésekhez és politikai reklámokhoz is mellékel olyan linkeket, amelyek hiteles információkat tartalmazó oldalakra mutatnak.

De fel lehet emlegetni azt is, hogy megbízható forrásként tüntették fel a szélsőjobbos Breitbartot, vagy hogy a Facebook tele van konteós oldalakkal, beleértve ebbe az egyértelműen káros oltásellenes mozgalmat is, az ő oldalaikat pedig hiába jelenti az ember, ezeket nem törlik. A Facebook és a gyűlöletbeszéd bizarr kapcsolata egyébként a hirdetőknek is feltűnt már. Több nagy cég, köztük az Unilever, a The North Face és a Levi's éppen a napokban függesztette fel a maga hirdetéseit júliusra a platformon, hogy tiltakozzon a cég döntésképtelensége ellen, a Coca-Cola pedig ugyan a bojkotthoz hivatalosan nem csatlakozott, de az összes közösségi platformon befagyasztotta a hirdetéseit.

Ez az egész pedig egy elég furcsa kettősségben kristályosodik ki, egyértelmű ugyanis, hogy a memék esetében sokszor röhejes mértékben túlműködő, de egyébként is felfoghatatlan mennyiségű tartalmat eltávolító moderáció nem valósulhat meg egyszerre a cég vezetőinek megszólalásaiból kikövetkeztethető, már-már extrém szólásszabadsággal.

Azt persze érdemes kiemelni, hogy a cégnek és a moderátoroknak egy szinte végtelen tényezős szempontrendszerben kell lavíroznia a tartalomellenőrzés során az alapesetben is sokat kritizált, jelenleg pedig még nagyobb terheléssel küzdő Facebookon.

Az mindenképpen jó hír, hogy láthatóan ez a krízis sem okozott katasztrofális összeomlást, az viszont megint kiderült, hogy jelen állás szerint Mark Zuckerbergék sem képesek tökéletesen moderálni egy ekkora platformot. Ezzel természetesen a Facebook is régóta tisztában van, múlt decemberben a londoni irodájukban tartott sajtóeseményen is leszögezték, hogy minden hibát egyszerűen képtelenség lenne kiszűrni, így elsősorban az a cél, hogy a lehető legalacsonyabb szinten tudják tartani ezek mértékét.

A mesterséges intelligencia nagyobb arányú használatával és a moderátorok számának csökkenésével ugyanakkor kellett kompromisszumokat kötniük, így bizonyos dolgokra egyszerűen nem jutott annyi idő, mint korábban. Ide tartozik például a spam, de még a Facebooknak elméletileg kiemelten fontos extrémizmus elleni harc is, ahol az elmúlt időszakban kénytelenek voltak a legnagyobb fenyegetésekre és a visszatérő szereplőkre fókuszálni, így az ilyen eszméket támogató csoportok és bejegyzések nagyobb eséllyel kerülték el a tiltást.

Ezen a téren ugyanakkor a Facebook láthatóan törekszik a transzparenciára, a májusban kiadott Community Standards Enforcement Report nevű, alapvetően a közösségi irányelvek betartatására vonatkozó jelentésben ugyanis viszonylag sok szó esett a mesterséges intelligenciáról, illetve arról, hogy miként használja fel azt a cég a szabályozás során. A jelentés a járvány miatt kialakult trendekre nem világított rá teljes mértékben, mert csak március végéig tartalmazott adatokat, de ebből, illetve a vele egy időben kiadott blogposztokból egy sor érdekesség kiderült a cég módszereivel kapcsolatban.

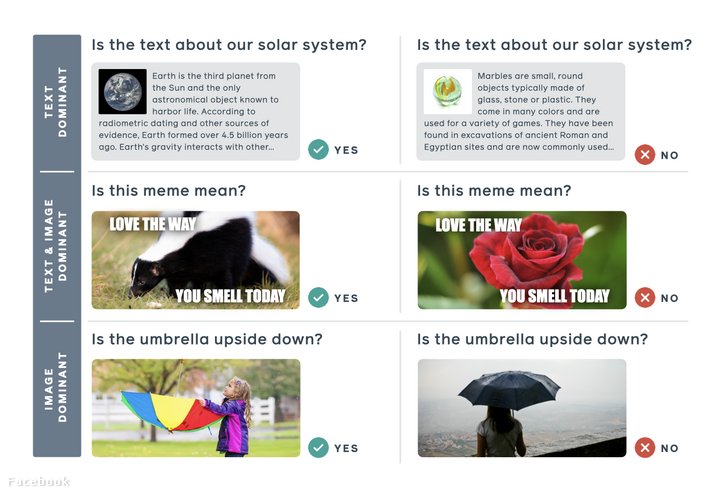

Ezek közül a leginkább figyelemre méltó éppen a fontos sarokpontnak számító gyűlöletbeszédről szóló bejegyzés volt, ahol a Facebook a jelenség kordában tartásának nehézségeiről értekezett. A cég arra a nem túl meglepő következtetésre jutott, hogy ennek mostanra jelentős része képeken és videókon zajlik, a sértő memék esetében pedig gyakran a képnek és a mellékelt szövegnek egyszerre van jelentése. Mint írták, mesterséges intelligenciával ezt elég nehéz szűrni, nemcsak mert a szójátékok és a nyelvbéli különbségek miatt ez eleve nagyon komplex feladat, hanem azért is, mert az algoritmusnak fel kell ismernie a kép másolatait vagy minimálisan módosított változatait is. Az igazi érdekesség az, hogy a Facebook saját állítása szerint

létrehozott egy olyan modellt, ami pontosan erre képes.

A SimSearchNet nevű rendszert a koronavírus-járványon keresztül mutatták be, és ezen a fronton nem is teljesített rosszul. A rendszer egészen pontosan úgy működik, hogy ha egy képről a független tényellenőrzők valamelyike megállapította, hogy félrevezető vagy hamis információkat tartalmaz a vírusról, akkor onnantól kezdve képes megtalálni a majdnem ugyanolyan képeket, és azokra is rátenni a figyelmeztető plecsnit – ez egyébként szintén a Facebook saját bevallása szerint az esetek 95 százalékában eltántorítja az embereket a tartalmak megnézésétől. Ennél is fontosabb ugyanakkor, hogy a rendszer arra is képes, hogy különbséget tegyen az eredeti kép, illetve a módosított változatai között.

A cég a gyűlöletbeszéd esetében is a koronavírusos posztokhoz hasonló módszereket alkalmazott, amivel sikerült 88,8 százalékra növelni a mesterséges intelligencia által kiszűrt tartalmak arányát. 2020 első negyedévében összesen 9,6 millió tartalmat töröltek le a gyűlöletbeszédre vonatkozó irányelvek megsértéséért, és állításuk szerint itt is egyre inkább támaszkodhatnak a mesterséges intelligenciára. Azt ugyanakkor hozzátették, hogy itt sincs könnyű dolguk, mert a rizikós tartalmakat viccből vagy komolyan megosztók ezek módosításával igyekeznek kijátszani az algoritmust, azt pedig még nehezebb szűrni, ha valaki a gyűlöletbeszédet elítélő bejegyzésben maga is használja a platform védekező mechanizmusait beindító kifejezéseket.

A Facebook el is ismerte, hogy a memék ellen a felturbózott arzenállal sem nagyon tud fellépni, ezért létrehoztak egy tízezer képből álló adatbázist, amely "gyűlöletkeltő meméket" tartalmaz, melyek jelentését csak a szöveg és a kép kapcsolatának megértésével lehet dekódolni. Az adatbázis a nyilvánosság felé nem publikus, csak kutatók férhetnek hozzá, a cég pedig a példáknál is hasonlóan multimodális, ám csak mérsékelten bántó képekkel prezentálta a dolgot. Például egy borzról készült képpel, amire az van írva, hogy "imádom ma a szagodat". A Facebook modellje ezt elméletileg képes együttesen értelmezni, és kiszűrni a képet, valamint felismerni, ha ugyanez a szöveg egy másik borzos képre vagy egy rózsás képre kerül rá.

A cég az általuk gyűlöletkeltőnek titulált memékhez kapcsolódóan egy 100 ezer dolláros versenyt is hirdetett, melynek célja a lehető legjobb módszer megtalálása ezek szűrésére. Az, hogy ennek mi lesz az eredménye, egyelőre a jövő zenéje, de a Facebook hisz abban, hogy ezzel ők és más piaci szereplők is hatékonyabban léphetnek majd fel a gyűlöletbeszéd ellen. Ez kétségtelenül egy jó vállalkozának tűnik, és az is örvendetes, hogy más platformok mellett a Facebook is egyre inkább megfelel a két éve életre hívott Santa Clara-i irányelveknek, és egyre átláthatóbbá próbálja tenni a működését. Erre jó példa a korábban említett jelentés, illetve az is, hogy mindenkinek elérhetőek a közösségi irányelvek, az azonban teljesen egyértelmű, hogy bőven lenne még hova fejlődni.

Maga a moderációs folyamat továbbra is jótékony homályba vész – még újságíróként sem nagyon lehet róla kideríteni semmilyen konkrétumot –, és azt is nehéz látni, hogy pontosan miként mérlegelnek a fellebbezési folyamat során. Nem véletlen, hogy a Facebookot is belevették abba a közösségi projektbe, a Silenced.online-ba, ahol bárki bejelentheti a moderációval kapcsolatos negatív élményeit, az anekdotális bizonyítékok alapján pedig előbb-utóbb talán tisztulhat is majd a kép. Az mindenesetre biztos, hogy a jelenlegi helyzetben a szokásosnál nagyobb terhelés mellett nagyobb figyelem is vetül az online moderációra, ez pedig akár nagyobb transzparenciához, humánusabb technológiához, jobb irányelvekhez és egy egészségesebb internethez is vezethet – ha a nagy techcégek is úgy akarják.

How COVID-19 is intensifying content moderation’s flaws (Global Voices Advox)

How Facebook is using AI to combat COVID-19 misinformation and detect ‘hateful memes’ (The Verge)

No, the Internet Is Not Good Again (The Atlantic)

Community Standards Enforcement Report (Facebook)

Borítókép: Getty Images Hungary Fotós: Lynsey Addario

Elindult az Indamedia média és marketing-kommunikációs kiadványa.

További szakmai tartalmakért kattints és kövess bennünket!

MEGNÉZEM