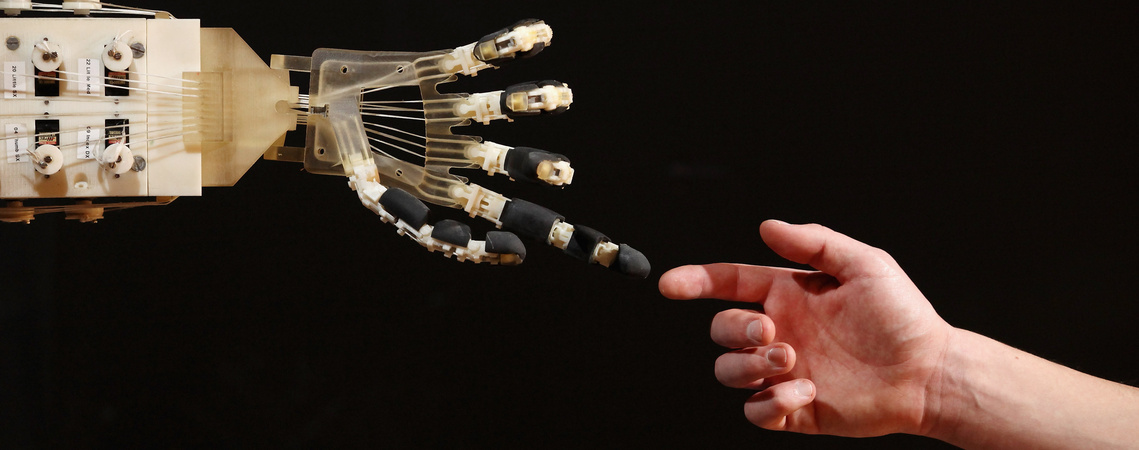

Robot ölt embert, ez már az apokalipszis?

További Tech cikkek

Bejárta a világsajtót nemrég, hogy egy robot megölt egy munkást a Volkswagen egyik németországi gyárában. Az eset természetesen szomorú, hiszen egy ember halálos balesetet szenvedett, ugyanakkor nem kell még a robotapokalipszis megérkezésétől tartanunk. A cég szerint nem gépi hiba történt, az alkalmazott tartózkodott rossz helyen, a robot ketrecében. Ugyanis éppen hogy nem valamilyen új generációs, szuperintelligens robotról van szó, amelyik öntudatra ébredve elpusztította a beállításaival machináló embert.

De még csak nem is az újabb fajta, már biztonságos együttműködésre kialakított ipari változatról, hanem egy régebbi típusról, amelyet még fizikailag elkülönítve dolgoztatnak, éppen az ilyen esetek elkerülése érdekében. Ráadásul az üzem szóvivője szerint már 1986-ban is történt egy hasonló halálos baleset egy automata gyártósoron, a világ első robot által okozott halála pedig még 1979-ben történt egy Ford-gyárban.

Jó kérdés, hogy ha nem a „robot” szó szerepelt volna a címekben, hanem mondjuk az, hogy „ipari baleset”, felkaptuk volna-e a fejünket a hírre. (Nem.) Ennek ellenére érdemes megnézni, mennyire vagyunk felkészülve arra az egyre kevésbé távoli jövőre, amikor a gépek egy-egy saját döntésükkel sértenek törvényt.

Nem csak robotol, fejlődik is

Ryan Calo, a Washingtoni Egyetem jogi professzora az ipari robotok többféle viselkedési módját különbözteti meg. A mechanikus, repetitív viselkedésű robotok nem tudják, mi az, amit csinálnak, csak csinálják, ahogy beállították őket (például akkor is megfognak és elmozdítanak, ha nem egy alkatrész, hanem egy ember feje van előttük). A másik, fejlettebb viselkedési formát nevezi Calo alakuló, menet közben létrejövő (emergent) viselkedésnek, vagyis olyannak, amely a programozói utasításokból indul ki, de nincs előre meghatározva, hanem a körülményekre reagál, és menet közben tanul.

Ebből adódhatnak hasznos dolgok és méretes melléfogások is, mint amikor a Google egyébként egyre okosabb képfelismerő algoritmusa gorillának nézte a fekete bőrű felhasználókat, vagy amikor az Amazon árazó algoritmusa 24 millió dollárra lőtte be egy könyv árát.

Calo szerint onnantól lesz érdekes a robotbiztonság kérdése, hogy ha a fizikai testtel rendelkező robotok is egyre inkább a tanulásra és fejlődésre képes algoritmusokhoz hasonló viselkedési mintákat kezdenek követni. Az ilyen esetekben ugyanis

Az angolszász jogrendszer megkülönbözteti a bűnös tudat (mens rea) és a bűnös cselekedet (actus rea) fogalmát. Eszerint bűncselekmény akkor állapítható meg, ha mindkettő teljesül, azaz az elkövető beszámítható volt, és szándékoltan tette, amit tett. Calo szerint, mivel ezek a robotok nem rendelkeznek önálló tudattal, a programozóik pedig nem bűnelkövetésre programozták őket, megjelenhet az elkövető nélküli bűntény számos problémát felvető kategóriája.

Erre mutatott szemléletes példát az a művészeti projekt, amelyben egy robot véletlenszerű netes vásárlásaiból rendeztek kiállítást tavaly ősszel. A robot több teljesen legális termék mellett olyasmit is bedobott a kosárba, amelyért egy emberi vásárló már büntethető lenne. Vásárolt például hamis márkájú ruhát, ecstasytablettákat és egy beszkennelt magyar útlevelet is. (A rendőrség ugyan megvárta a kiállítás végét, de utána lecsapott, és mégiscsak elkobozták a kiállított tárgyakat és a vásárlójukat is.)

Viszont ebben az esetben a robotot programozó művészek, noha nem bűnelkövetésre tervezték az algoritmust, tudhatták, hogy valami ilyesmi fog kisülni a dologból, ha ellenőrizetlenül ráeresztik a darknetre, így emiatt a felelőtlen magatartás miatt mégiscsak megállapítható lehet a felelősségük. Calo szerint a valódi fejtörést az fogja okozni, amikor egy hasznos munkára tervezett robot fejlődik olyan irányba, hogy bűnt kövessen el. Közelebb áll ehhez az a vásárlóbot, amelyet azért írt a gazdája, hogy ártatlan meglepetéseket rendeljen neki az Amazonról, ahol viszont előfordulnak olyan termékek, amelyek az egyik államban legálisak, a másikban viszont nem.

Újratervezés: a sarkon forduljon fel

Persze az igazi dilemmát azok a helyzetek okozzák, amelyekben a törvénysértés élet-halál kérdése. Erre a legköznapibb és egyre elterjedtebb példa az önvezető autók kérdése. Az egyre inkább elfogadott, hogy a robotautók képesek biztonságosan vezetni, a jelenleg tesztelt változatok baleseti statisztikái alapján az összes eddigi probléma is emberi hiba miatt történt. És éppen ebben jelenthetnek előrelépést: az emberi tényező – fáradtság, figyelmetlenség, ittas vezetés – miatt bekövetkező balesetek elkerülésében.

A Wired egy korábbi cikke szerint joggal feltételezhető, hogy az évi 32 ezer amerikai közúti haláleset 16 ezerre csökkenthető önvezető autókkal. A dilemmát az okozza, hogy ez nem úgy jönne össze, hogy 16 ezer potenciális halál elmarad, és mindenki boldog. Valószínűleg az autók döntései miatt sokan nem halnának meg, mások viszont, akik eredetileg életben maradtak volna, áldozattá válnának. Így valójában a nettó eredmény masszívan javulna, de a gépek döntenék el, ki marad életben, ki nem. Összességében persze így is jobban jönnénk ki a dologból, de némileg kényelmetlen utóízt adhat a javuló statisztikáknak, hogy a gépek osztották a lapokat.

Egy robotautó joggal dönthetne például úgy, hogy inkább az egyetlen utasa veszítse életét, mint az a harminc gyerek, akinek a buszába amúgy beleütközne.

További dilemma, hogy áthághatja-e a szabályokat egy robot, ha ezzel életeket menthet meg. Áthajthat-e magától a záróvonalon egy üres sávba, ha egyébként akadályba ütközne, ahelyett, hogy megtorpanással okoz fennakadást? Gyorsíthat-e a limit fölé, hogy ne ütközzenek bele? És további kérdések sorát kell még megválaszolni, mire egyszer valóban elterjedhetnek az utakon az önvezető autók.

Az igazi gépfegyver

Sokkal közvetlenebb viszont a személyzet nélküli katonai rendszerek kérdése. Elsősorban nem a távirányítású drónokról van szó, hanem a célpontot autonóm módon kiválasztó, saját döntése alapján tüzet nyitó fegyverekről. Ezek a rendszerek abban különböznek a többi robottól vagy több-kevesebb autonómiát mutató szoftvertől, hogy definíció szerint gyilkolásra születtek. Az ezzel kapcsolatos döntéseket pedig nemcsak morális okokból problémás teljes egészében kiengedni az emberi kézből, hanem azért is, mert egy kis hiba is nagyon könnyen komoly konfliktusba fordulhat.

Emiatt számos kutató az ilyen autonóm fegyverek használatának nemzetközi egyezményben való tiltását szorgalmazza. Köztük például Mark Bishop, aki a Londoni Egyetem kognitív számítástechnika-professzora, egyben a robotfegyverek ellenőrzéséért felelős nemzetközi bizottság (ICRAC) tagja is. Bishop szerint nem is a mesterséges intelligencia (MI), hanem éppen hogy a mesterséges butaság, vagyis

Nincs már messze a rendőrség robotizálása sem, a lehetőség legalábbis egyre közelebb kerül. A mesterséges intelligencia által vezérelt robotzsaruk bevezetése, az emberi kontroll akár részleges feladása az utóbbi idők amerikai rendőri túlkapásainak fényében különösen nyugtalanító gondolatnak tűnik.

Ugyanakkor éppen az emberi ítélőképesség kudarcát példázó hibás rendőri döntések világítanak rá arra, hogy a kérdés nem is olyan egyszerű. Nem jelenthető ki, hogy egy megvesztegetésre és érzelmi-ideológiai elfogultságra egyáltalán nem fogékony robotzsaru rosszabbul végezné a dolgát.

A jogvédő Human Rights Watch idén áprilisi jelentése szerint a legnagyobb probléma az autonóm fegyverekkel és rendőrökkel, hogy ha hibáznak, szinte lehetetlen megtalálni a felelőst. Bonnie Docherty, a jelentés vezető szerzője szerint

Ha egy teljesen autonóm fegyver bűnt követ el, valakit felelősségre kellene vonni, ha pedig senkit nem lehet, akkor ezeket a fegyvereket be kellene tiltani.

Michael Horowitz biztonsági szakértő máshogy látja. Szerinte a felelősség kérdését nem a ravasz meghúzásának szintjén kell nézni, hanem hogy az adott küldetést melyik tiszt irányítja. Horowitz szerint egyébként is korai még a szabályozásról beszélni és tiltást követelni, amíg magát a kérdéses technológiát sem értjük teljesen. Ennek szerinte az a veszélye, hogy ha túl széles körű tiltás születik, akkor olyan fegyverek is tiltólistára kerülhetnek, amelyek valójában csökkentenék a civil áldozatok számát.

Robotbűnök, közerkölcsök

Az ember és gép, személy és eszköz közötti éles határvonal mindenesetre egyre nehezebben meghúzható. Ki a bűnös, mi a bűn, megállapítható-e szándékosság egy gépnél, és kié a felelősség, ha gyilkolni kezdene a házirobot? Minél kisebb a gép autonómiája, vagyis minél inkább emberi irányításra hagyatkozik, annál inkább a felhasználó viseli a felelősséget.

Viszont az autonómia növekedésével egyre inkább függetlenedik majd a robot a gazdájától. Kérdés, hogy ilyenkor a felelősség áthárul-e a robot tervezőjére, programozójára, gyártójára? Minél inkább autonóm lesz egy rendszer, annál kevésbé.

Ha valami rossz történik, az okozati lánc egyre hosszabbá válik. Vannak módszereink a jelenlegi jogban, hogy megállapítsuk a felelősséget, de ha a technológia autonómabbá válik, nem biztos, hogy ezeknek továbbra is lesz értelmük

– mondta Kate Darling, az MIT Media Lab kutatója. Egy emberi tulajdonságokra szabott jogrendszer eszközeivel kellene választ találni a robotok rohamos terjedése nyomán felmerülő jogi kérdésekre, márpedig a szakértők szerint erre messze nem vagyunk felkészülve.

Munkásököl vasököl, oda üt, ahova köll!

A filmekből ismert autógyári robotokat dizájnos, univerzális, felhőalapú, nyílt szabványú robotok váltják le. És elveszik a munkát az ember elől.

Mivel az egész MI- és robottéma még mindig elég sci-fiszerűnek tűnik, nem csoda, hogy ma is gyakran előkerül a robotika három alaptörvénye, amelyeket Isaac Asimov sci-fi író alkotott meg, az első változatot még 1942-ben. Ezek az ember-robot együttélést voltak hivatottak szabályozni, garantálva az ember biztonságát az intelligens gépek között. A törvényeket újra és újra előveszik, átírják, kidobják a terület tudósai is, de leggyakrabban egyszerűen alkalmatlannak minősítik tudományos használatra.

Két német tudós, Ulrike Barthelmess és Ulrich Furbach szerint például nincs rájuk szükség, mert a félelmeink sokkal inkább kulturális alapúak, mint technológiaiak. Szerintük az alkotóját elpusztító gép nemcsak a sci-fik népszerű témája, de Frankensteintől a Gólemig számos történet épít erre a mintára, amely valójában abból a vallásos toposzból ered, hogy ha az ember megpróbál istent játszani, megbűnhődik. A kutatók szerint a legtöbb robot tervezéséből adódóan az ember védelmét szolgálja, amelyik mégse, azt pedig emberek használják pusztító célra, így a hagyományos joggyakorlat képes kezelni ezt a kérdést is.

Azonban nem minden tudós ilyen optimista a jogrendszerrel kapcsolatban. Gabriel Hallevy, egy a robotok és a büntetőjog találkozásával foglalkozó kutató szerint például a probléma lényege, hogy manapság jogi vákuumban élünk, és éppen azért, mert a gép egyre függetlenebb az embertől,

Úgy gondolja, hogy a felelősség nem erkölcs kérdése, hanem kizárólag a tudatosságé (awareness). Ahogy egy céget is el lehet számoltatni jogi személyként, Hallevy szerint egy robotnak sem kell gonosznak lennie, elég, ha tudatában van annak, mit tesz, ez pedig se a robot, se az ember esetében nem több a világról szóló tényszerű információ érzékelésénél és feldolgozásánál.

Hallevy konkrét példákat is ad arra, milyen ítéleteket lehetne hozni egy bíróság elé citált robot esetében.

odáig terjednek, hogy egy robotról is megállapítható, hogy beszámíthatatlan (ha vírusos vagy meghekkelték), vagy hogy önvédelemből cselekedett.

Egy másik kutató, Steve Omohundro szerint nem teljesen emberi módon, de még a büntetés elrettentő ereje is működhetne az intelligens robotok esetében. A tudós példájában ha egy robot működésének célja, hogy minél jobban sakkozzon, és beleprogramozzák, hogy ha embert öl, kikapcsolják, ez segíthetne, hogy ne tegyen ilyet, hiszen tudná, hogy kikapcsolt állapotban nem lenne lehetősége sakkozni.

Samir Chopra New York-i filozófiaprofesszor szerint az a gond az autonómiával, hogy az emberek úgy beszélnek róla, mintha csak kétféle lehetne (igen/nem), pedig célszerűbb skálaként gondolni rá.

Az autonómia a nullától, amilyen egy darab kő, a teljesen autonóm felnőtt emberig terjed. És a kettő között számos variáció képzelhető el.

Chopra szerint a ma is működő, többé-kevésbé intelligens programok éppen a a skála közepét foglalják el. Ahhoz túl függetlenül működnek, hogy egyszerű eszközként tekintsünk rájuk, ahhoz viszont nem eléggé, hogy jogi személyként kezeljük őket. Chopra szerint ezért a jognak különálló kategóriaként, olyan jogi ágensként kellene őket meghatároznia, amely úgy kötődik az őt működtető vállalathoz, mint egy buszsofőr a tömegközlekedési társasághoz: bizonyos felelősséget ő visel, de a cég is felelősséggel tartozik a cselekedeteiért. Chopra szerint ez a megközelítés egyszerre ismeri el, hogy a robotok képesek olyasmire, amit előre senki sem láthatott, és hogy ennek ellenére a tervezőiknek is nagy a felelősségük abban, hogy a gondos tervezéssel minimalizálják a káros működés lehetőségét.

Ez utóbbi pont, a tervezés már csak azért is fontos, mert több szakember szerint valójában ezen áll vagy bukik az egész kérdés.

Ember tervez, robot végez

Több MI-kutató szerint a biztonsági aggályok megválaszolása elsősorban nem törvénykezési, hanem mérnöki feladat, a gondos tervezés és programozás képes leghatékonyabban kiiktatni a potenciális veszélyt. Már csak azért is, mert a legvalószínűbb, hogy az MI valójában nem ellenséges, hanem többnyire közömbös lesz az emberiség iránt, ezért

Éppen ezért több kutatás jelenleg is folyik a témában. Július elején indult be az a projekt, amelyet nagyrészt az MI-veszély leghangosabb szószólója, Elon Musk pénzel. Ebben több mint kétmilliárd forintnyi pénzt osztanak szét 37 kutatócsoport között. A kutatások célja a biztonságos MI kereteinek kidolgozása és az etikai alapelvek meghatározása. Az egyik csoport olyan rendszert akar létrehozni, amely képes valós helyzetekben egy előre meghatározott értékrendszer alapján, kvázierkölcsi alapon dönteni. Egy másik adatbázist hozna létre az autonóm fegyverek kontrolljára. Mások a legpesszimistább forgatókönyvekre készülnének fel.

A Terminátor-forgatókönyv veszélye nem az, hogy megvalósul, hanem hogy elvonja a figyelmet az MI valós kérdéseiről

– mondta Max Tegmark, a támogatásokat szétosztó intézet elnöke.

Ami biztos, hogy a robotok nemcsak egyre fejlettebbek, de egyre többen is vannak. Ez szinte felmérhetetlen haszonnal jár az élet számos területén, de legalább ekkora kihívást is jelent. Hiába van még nagyon távol a valódi mesterséges intelligencia, a robotok által akár véletlenül, akár direkt elkövetett bűntettek jóval közelebbi problémája egyre kevésbé lesz beszorítható a jelenlegi jogi keretek közé. A kérdés ma még inkább elméleti viták tárgya, de az általános irány jól látszik: meg kell találni azt az egyensúlyi helyzetet, amely érdekeltté teszi a gyártókat a minél alaposabb biztonsági megoldások alkalmazásában, de nem veszi el a kedvüket a további fejlesztésektől.

Az oldalról ajánljuk

- Külföld

Olyan mértékű büntetést szabtak ki a Greenpeace-re, amely csődbe viheti a szervezetet

Zaklatás, rágalmazás és birtokháborítás miatt perelte be őket egy olajcég.

március 21., 09:10

- Gazdaság

Újabb bank merített hatalmasat a húsosfazékból

Kiemelkedő, sikeres, milliárdokban gazdag 2024-et tudhat maga mögött az MBH Bank.

március 21., 09:29

- Külföld

Újabb csúcstalálkozót tart a „tettre készek koalíciója” Párizsban

Emmanuel Macron jelentette be a hírt.

március 21., 09:26

- Gazdaság

Ingatlanvásárlás 3 százalékos kamattal? Lehetséges, de nem mindenkinek

Van azonban buktató, ami súlyos milliókba fájhat.

március 21., 08:02

- Atlétika

Áttörés az M4 Sporton: világszerte minden magyar nappalijába beköltözik a nancsingi fedett pályás vb

Az internet tényleg leküzdi az országhatárokat.

március 21., 09:20

- Belföld

Rá sem ismerünk a Kárpát-medence időjárására, nem a fűtésre költünk majd legtöbbet

Szegedi tudósok kutatócsoportja vizsgálja, miért kezdett el a város klímája Rómáéhoz hasonlítani.

március 21., 09:06

- Külföld

Csehország határellenőrzést vezet be a Magyarországon is terjedő halálos kór miatt

A cseh rendőrség megelőző intézkedéseket jelentett be.

március 21., 08:51

- Külföld

Donald Trump aláírta a rendeletet az oktatási minisztérium megszüntetéséről

Ezzel beváltotta egyik kampányígéretét.

március 21., 08:33

- Belföld

VSquare: Orbán Viktor utasította a titkosszolgálatot a külföldről támogatott civilek és újságírók listázására

Kérdéses, mit kezd a kormány a jelentéssel.

március 21., 07:23

- Reklám

Ez a filmecske két perc alatt olyat mutat, amire évtizedek múlva is emlékezünk

Mindenkiről szól.

március 21., 05:54

- Külföld

Bécsben is tüntettek a magyar Pride betiltása ellen

Több százan voltak jelen az eseményen.

március 21., 09:54

- Futball

Az utolsó másodpercekben döntött Vinícius Júnior, kulcsfontosságú meccsen nyertek a brazilok

Ezzel négy pontra közelítették meg a listavezető argentinokat.

március 21., 10:04

- Cinematrix

A nőnek csak kussolni volt szabad – film, amely lenyomta a Barbie-t és az Oppenheimert is

A verés állandó, a nő cselédnek sem jó.

március 21., 09:52

- Kultúr

Ez a doboz meghatározta a rendszerváltás előtti időszakot, az állam játékszerként használta

Azt remélik, nem tér vissza.

március 21., 05:55

- Belföld

Az a baj, hogy a vásárlók nem értik az áruházi kínálatot – vizsgálódik a GVH a teljes kiőrlésű termékek körül

Minden tizedik magyarnak fontos lenne, hogy a boltok ne csaljanak.

március 21., 05:54

- Külföld

A náci propagandaminiszterhez hasonlította a leendő német kancellárt a korábbi orosz elnök

Kemény vádat fogalmazott meg Dmitrij Medvegyev.

március 21., 07:34

- Belföld

Orbán Viktor: A külföldiek értsék meg, hogy a magyarokat nem lehet kifosztani

A kormányfő ezúttal is Brüsszelből jelentkezett.

március 21., 07:44

- Belföld

Éjszakai fagyok és szikrázó napsütés, nagy hőingásra számíthatunk

A legmagasabb nappali hőmérséklet döntően 13 és 18 fok között alakul.

március 21., 06:05

- Belföld

Gulyás Gergely Magyar Péterről: Bolondokkal lehet barátkozni, árulókkal nem szabad

A miniszter egy interjúban beszélt a Tisza Párt elnöke és közötte lévő kapcsolatról.

március 21., 06:05

- FOMO

A filmvászon kaméleonja, akinek a lábai előtt hever a szakma

67 éves lett Gary Oldman.

március 21., 05:59

- Külföld

Miért engedi az Egyesült Államok az oroszok területi terjeszkedését?

A Kreml remek lehetőséget lát, hogy kedvező alkut kössön.

március 21., 06:55

- Külföld

Tűz ütött ki Európa legnagyobb repülőterénél, egész napra bezártak

Az incidensben több mint ezer járat érintett.

március 21., 06:32

- Külföld

A lengyel belügy arra kéri az embereket, hogy három napra elegendő élelmiszerrel készüljenek fel a válsághelyzetekre

Új védelmi stratégiát dolgozott ki a kormány.

március 21., 06:52

- Külföld

Donald Trump ellenségeskedése miatt felmerült, hogy Kanada az Európai Unióhoz csatlakozna

Egyáltalán lehetséges ez?

március 21., 06:55

- FOMO

Alig két év házasság után újra válik Sia

Az énekesnő második házassága is tönkrement.

március 21., 06:10

- Belföld

Három férfi erőszakolt meg egy nőt egy 11 éves gyerek szeme láttára

Az elkövetőket letartóztatták.

március 21., 09:38

- Külföld

2024-ben mintegy négyezren választották az eutanáziát Belgiumban

Az igénylők száma 16,6 százalékkal növekedett egy év alatt.

március 21., 07:13

- Belföld

Mintegy félmilliós tartozása miatt vertek agyon egy nyugdíjas taxist Pestszentimrén

A feltételezett gyilkost órákon belül elfogták.

március 21., 05:59