- Tech-Tudomány

- technika

- mesterséges intelligencia

- nyelvi modell

- gpt-3

- openai

- microsoft

- nvidia

- deepmind

Menetelnek a fogalmazó mesterséges intelligenciák

További Tech-Tudomány cikkek

2020 nyarán hatalmas szenzáció volt a GPT-3 transzformer nyelvi mesterséges intelligencia. Elon Musk egyik legkevésbé ismert cége, az OpenAI olyan programot fejlesztett, ami képes olyan szöveget generálni, ami teljesen értelmes és komolyan hihető, hogy ember írta. Nem sokkal bemutatkozása után egy GPT-3 által írt cikk lett a legolvasottabb a Hacker News hírgyűjtőn, ami nevéből következően műszaki érdeklődésű olvasók csoportja által látogatott honlap. Volt, aki gyanakodott, de a közönség csak végén szembesült a ténnyel, hogy gép generálta az általuk kedvelt szöveget.

Rögtön megjelentek az írással kapcsolatos szakmák gyors megsemmisülésével kapcsolatos víziók. Kérdés, hogy mit gondoljunk most, másfél évvel később, amikor még durvább képességű modellekkel álltak elő a versenytársak? Természetesen azt, hogy a víziók pontosak.

Több, nagyobb, és talán jobb

A Google már 2021 elején előrukkolt új fejlesztésével, a billió paraméteres LLM modellel. A nyelvi intelligenciáknál a paraméterek szám egyfajta teljesítménymerőként működnek, de a dolog természetesen nem ilyen egyszerű. A 175 milliárd paraméteres GPT-3 eltörpül az 1,6 ezer milliárd paraméteres LLM mellett. Az LLM azonban főként egy hatékonyságot növelő fejlesztés, amelynek lényege, hogy a modellt úgynevezett szakértőkre osztják. A szóban forgó esetben például a szakértők egyes nyelveket jelöltek, konkrétan 11 nyelvet, amelyeket nagyon hatékonyan tudott fordítani, ami önmagában is nagy fegyvertény.

Az LLM bejelentése minden esetre jótékonyan fedte az egy hónappal korábban kirobbant botrányt, amit az okozott, hogy a cég kirúgta a mesterséges intelligencia fejlesztésekkel kapcsolatban etikai aggályokat megfogalmazó szakértőket. Az etikai osztály beszántása miatt szolidaritásból felmondó munkatársak közül az Apple cseresznyézett ki magának.

Az Alphabet másik cége, a sakkozó és hallucináló mesterséges intelligenciákra szakosodott DeepMind is beszállt a nyelvi modellek fejlesztésébe. Gopher nevű mesterséges intelligenciájuk ugyan negyedakkora, mint a januárban megszellőztetett LLM, 280 millió paraméterével azonban nagyot lépett előre a pontosság terén, az emberi szakértő teljesítmény felé. A DeepMind csapata nem csak a versengésbe szállt be, de csorba kiköszörülésén is dolgoznia kellett, ezért külön dolgozatban elemezték a nyelvi modell etikai problémáit, a betanítása során bekerülő előítéleteket és toxikus nyelvezetet.

A DeepMindot megelőzte a Microsoft és az Nvidia októberben bejelentett közös modellje, a Megatron-Turing Natural Language Generation modell a maga 530 milliárd paraméterével. Ide tartozik továbbá a kínai Huawei saját modellje az áprilisban bejelentett 200 milliárd paraméteres PanGu-Alpha.

A nyelvi mesterséges intelligenciák terén tehát kőkemény a verseny, és a csatát az nyeri, aki több és erősebb számítógépet tud bevetni. A Microsoft-Nvidia esetében ez 560 Nvidia DGX A100 szervert jelent, egyenként 8 darab 80 gigabájtos videókártyával.

A szörnyeteg

Az OpanAI sem pihent a babérokon: a GPT-3 százszor erősebb volt, mint az előd GPT-2, a következő ugrás azonban ötszázszoros lesz. A GPT-4 100 billió paraméterrel dolgozik majd, az irgalmatlan számokkal dobálózásnál azonban tényleg fontosabb a hardver. Ezen a téren az OpenAI komoly újításokkal dolgozik. Korábban a Microsofttól bérelték a GPU-kban gazdag infrastruktúrát, azonban 2019 óta a Cerebrasszal dolgozik.

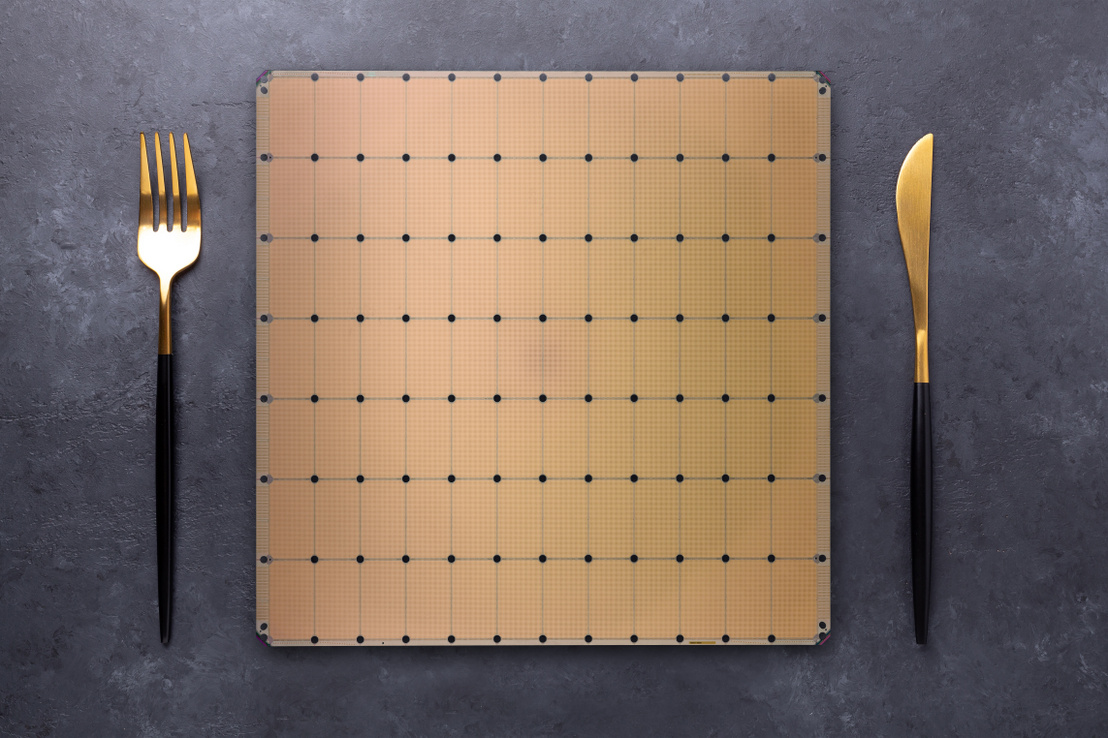

A Cerebras neurális hálókra szakosodott processzorokat gyárt, a Wafer Scale Engine Two (WSE-2) chipjük a legnagyobb a piacon. Tényleg: 22 centiméteres szélességű és hosszúságú szilícium, amire 2,6 billió tranzisztort építettek. Ennél is többet mond, hogy egy ilyen célra használt grafikus processzorban több száz mag dolgozik, a WSE-2-n viszont 850 000 mag van, és bár így energiahatékonyak is, külön hűtőrendszert kellett fejleszteni a processzorhoz.

Mielőtt a GPT-4 megérkezik érdemes tudni, hogy az emberi agy 80-100 milliárd idegsejtből áll, ez nagyjából a nyelvi intelligenciák paramétereinek a nagyságrendje. Egy idegsejt működésének modellezéséhez egy friss tanulmány szerint azonban öt réteg neurális háló szükséges. Ez azt jelenti, hogy ezer mesterséges neuron modellezése ér fel egy valódi idegsejttel.

(Dice, The Next Web, Towards Data Science, VentureBeat)

(Borítókép: Jó étvágyat - a Cerebras WSE-2 chipje. Fotó: Elizeveta Elesina / Getty Images Hungary)