- Tech

- mesterséges intelligencia

- mi

- gépi tanulás

- mélytanulás

- gpu

- nvidia

- microsoft

- intel

- csip

- csipgyártás

Elkezdődött a háború a csipgyártás jövőjéért

– De... de hát nagyuram, miért mondod ezt? Páratlan varázslatokat hajtottál végre ezzel a pálcával.

– Nem. A megszokott varázslataimat hajtottam végre vele. A mágiám páratlan, de ezé a pálcáé... nem az. Csodákat ígért, és azok elmaradtak.

A fenti párbeszéd a jobb sorsra érdemes Piton professzor és Voldemort között zajlott le, amikor utóbbi úgy érezte, még a Pálcák Urával se tudja valóra váltani a benne rejlő potenciált. Valahogy így érezhetik magukat manapság a mesterséges intelligencia (MI) kutatói is: bár az általuk kifejlesztett technológiák páratlan dolgokat ígérnek a társadalomnak, a hardver korlátai a Sötét Nagyúréhoz hasonlóan az ő lehetőségeiket is szűkre szabják.

Az MI-kutatás ugyanis az utóbbi pár évben a reneszánszát éli, és hiába a szoftver, vagyis az MI-algoritmusok produkálják a látványos eredményeket, ezeknek a működéséhez szükség van speciális hardverre is, amelyen hatékonyan futtathatók. Bár az utóbbi években ezen a téren is nagyot léptünk előre, a szűk keresztmetszetnek még mindig az iszonyatosan számításigényes MI-rendszerek meghajtása bizonyul. (Még akkor is, ha vannak olyan feladatok is, amelyekben a csipek járnak előrébb, és éppen az algoritmus nem elég hatékony.)

Hardveres oldalon az Nvidia emelkedik ki, a cég elképesztő sikerének fő oka, hogy gyakorlatilag egyeduralkodónak számít a gépi tanuláshoz szükséges grafikus csipek piacán. De már jönnek a speciális MI-csipek, a nagy techmamutok és a kis startupok is sorra szállna be a versenybe, az MI-csipháború pedig veszélybe sodorhatja az Nvidia egyeduralmát, és az egész piac a feje tetejére állhat. Na persze ők se hagyják magukat.

MI ez az egész felhajtás?

Aki manapság tetszőleges híroldalon felcsapja az internetet, nem nagyon tud úgy olvasgatni, hogy ne botlana bele valamilyen mesterséges intelligenciás fejlesztésbe. Az MI szinte mindenben ott van: a képfelismerést lehetővé tevő számítógépes látás, a hangvezérlésű digitális asszisztensek beszédfelismerése, a valós idejű szövegfordítás, az önvezető autók, a pontosabb rákdiagnózis vagy éppen a személyre szabott gyógyszerek is mind ezen alapulnak.

Pontosabban a gépi tanuláson. A “mesterséges intelligencia” ugyanis nem egyetlen konkrét módszert jelent, és az utóbbi évek leglátványosabb eredményei főleg a gépi tanulás nevű ágára épülnek. Ennek a lényege, hogy egy rendszert nem manuálisan programoznak be valamilyen konkrét feladatra, hanem sok-sok adattal tréningezik, hogy magától fejlődjön.

A gépi tanuláson belül is létezik többféle módszer, az egyik az idegrendszer biológiai modelljéről mintázott neurális hálóké (neural net, NN). Ezekre megint csak többféle megközelítés épül, a legnépszerűbb a mélytanulás (deep learning). Ennek a lényege, hogy a különböző típusú adatokat sok-sok külön rétegben dolgozza fel, amelyek egymásra épülnek (ettől mély). Ez a gyakorlatban arra jó, hogy az algoritmusokat strukturálatlan adatbázisokra is rá lehet ereszteni, vagyis nem kell például több ezer képet előre felcímkézni, hanem a gép a kép egyszerűbb mintázataitól a specifikusabbak felé haladva felismeri, hogy mit lát (ettől tanulás).

Ezek a mélytanulásos neurális hálózatok (deep neural network, DNN) viszont iszonyatosan számításigényesek. Ez az oka annak, hogy bár már régóta léteznek ilyenek, egészen a közelmúltig nem sokra mentek velük. Az MI-reneszánszhoz alapvetően három dolog kellett: egyrészt a szoftver, vagyis jó mélytanuló algoritmusok; másrészt rengeteg adat, amellyel ezek tréningezhetők; harmadrészt a hardver, ami elbírja ezeknek az algoritmusoknak a futtatását. Ez a hardver pedig a grafikus processzor (GPU).

A GPU váratlan hódítása

Míg a hagyományos kódot emberek írják és szekvenciális, vagyis szép sorban végzi el a számításokat, a mélytanuló algoritmus öntanuló és párhuzamos számításokra épül. Előbbit a hagyományos processzorok, a CPU-k remekül kezelik, de a gépi tanulás nagy adatmennyiségét és párhuzamos számítási feladattípusait a GPU-k sokkal hatékonyabban tudják kezelni.

A hagyományos processzor persze továbbra is megkerülhetetlen, csak a párhumazos számítási feladatokat lepasszolja a GPU-nak. Leegyszerűsítve: a kevés maggal és több memóriával rendelkező CPU kevesebb dologra tud hosszabb ideig figyelni, míg a rengeteg maggal bíró GPU sok-sok apró, ismétlődő feladatra egyszerre.

Az egyre fejlettebb és olcsóbb grafikus processzorok pedig egyre nagyobb párhuzamos számítási kapacitást tesznek lehetővé. A nagy robbanás néhány éve jött el. Az öntanuló DNN-ek először 2012-ben az ember által írt kódot gyűrték le képfelismerésben, majd 2015-ben jutottak el arra a szintre, hogy magánál az embernél is hatékonyabbá váltak ezen a téren.

Az Nvidia világuralma

Az Nvidia gyakorlatilag véletlenül lett az MI-kutatás hardveres motorja: az eredetileg videojátékokhoz és más, grafikailag intenzív feladatokhoz kitalált processzorairól kiderült, hogy a gépi tanuláshoz is kifejezetten passzolnak. A következő években a cég fokozatosan egyre inkább összpontosítani kezdett erre a területre, és direkt ehhez a feladathoz kezdte igazítgatni egyes csipjeit. Külön változatot fejlesztettek a pécén (GeForce), a felhőben (Tesla), a robotokban és drónokban (Jetson) és az autókban (DRIVE PX) futó mélytanulásos feladatok meghajtásához.

A fiúk a bitcoinbányában dolgoznak

A világ legnagyobb bitcoinfarmján Belső-Mongóliában 25 ezer számítógép napi 70 millió forintnyi virtuális pénzt termel. A helyiek számára itt karbantartónak lenni minden álommelók netovábbja.

A cég ma a GPU-piac 72,5 százalékát uralja (már ha csak a dedikált, és nem az CPU-val integrált grafikus vezérlőket számoljuk, mert utóbbiakkal az Intel vezet magasan), és a világ nagy adatközpontjaiban egyre inkább az ő GPU-ik végzik a gépi tanulásos feladatokat. Az Nvidia platformjára a világ legnagyobb techcégei építenek, legalább részben ezen fut a Google (Tensorflow), a Facebook (Caffe2), az IBM (Watson), a Microsoft (CNTK) és a Baidu (PaddlePaddle) mélytanulási keretrendszere is.

A cég grafikus processzorait persze továbbra se csak gépi tanulásra használják, a videojátékosok és újabban a kriptovaluták bányászai is nagyüzemben fogyasztják őket, és az Nvidia összességében az idei év első negyedévében 48 százalékkal tudta növelni a bevételét az egy évvel korábbihoz képest. A messze legnagyobb növekedést az adatközpontok piacán érték el: ezen a területen a cég első negyedéves árbevétele 186 százalékkal nőtt az egy évvel ezelőttihez képest, miután már az előző negyedévben is 205 százalékkal ugrott meg.

Közben viszont egyre inkább elérjük a mai grafikus processzorok határait, egyszerűen azért, mert eredetileg nem erre találták ki őket. Ezért megjelent az igény a kifejezetten erre a célra tervezett hardverre, és kezdenek egyre többen speciális MI-csipekkel kísérletezni, ami miatt lassan a gépi tanulásos aranyláz legnagyobb nyertesének is egyre inkább fájhat a feje.

A gépi tanulásos feladatok általánosságban két szakaszból állnak. Az első az algoritmus tréningelése, a második a már betanított algoritmus futtatása. A képfelismerő algoritmusnak például először sok-sok cicafotót kell nézegetnie, hogy megtanulja, hogy néz ki egy macska, aztán később élesben kap fotókat a felhasználóktól, amikről a korábban tanultak alapján megmondja, hogy macska van rajta.

A GPU elsősorban a tréningelésben teljesít jól. Ott viszont annyira, hogy ezen a téren még jó ideig nem kell tartani trónfosztástól – mondja Yann LeCun, márpedig ő tudja, miről beszél, mert ő a Facebook MI-laborjának vezetője. A végrehajtás fázisát viszont szerinte jelentősen átalakíthatják az új MI-csipek.

A Google ezt is inkább maga csinálná

A legjelentősebb kihívó a Google. A cég tavaly májusban mutatta be a Tensor Processing Unit (TPU) nevű csipjét, amely a méréseik szerint 15-30 százakékkal gyorsabb ugyanazokban a feladatokban, mint a hagyományos csipek, és 30-80 százalékkal energiahatékonyabb. A TPU hatékonysága spórolta meg nekik, hogy 15 új adatközpontot kelljen építeniük. Egyébként AlphaGo nevű góbajnokverő MI-ben is TPU-k ketyegtek.

Idén májusban pedig kiadták a csip második verzióját is TPU 2.0 vagy Cloud TPU néven. Ennek két fő újdonsága van. Egyrészt azért különleges, mert úgy tervezték, hogy a neurális hálók tréningelésében és végrehajtásában is használható legyen, szemben az első generációs TPU-val, amely a tréningelésre még nem igazán volt alkalmas. Másrészt – bár közvetlenül piacra dobni ezt se fogják – ezt a verziót már bárki használhatja majd az idén év végén beindítani tervezett új felhőszolgáltatásukon keresztül.

A Cloud TPU hátránya viszont, hogy kifejezetten a Google saját fejlesztésű szoftverkészletéhez, a Tensorflowhoz készült, ami akadályt jelenthez abban, hogy elterjedjen a használata. A Tensorflow ugyan ugyan nyílt platform, így bárki használhatja, de sok fejlesztő másik, rivális motorral (például Caffe vagy Torch) fejleszti a maga neurális hálóit. Így ha valaki élvezni akarja az új TPU előnyeit, alkalmazkodnia kell. Nyilván a szolgáltatás árán is sok fog múlni, a kutatók például a Google szerint ingyen használhatják majd, ha cserébe megosztják az eredményeiket a világgal. (Mindez persze legalább annyira szól a három felhőszolgáltató óriás, a Google-Amazon-Microsoft trió közötti pozícióharcról, mint magáról az MI-ről, de ez már egy másik történet.) Mindenesetre a Google felhőjében a GPU-k is elérhetők maradnak a fejlesztőknek, és ezek nagy előnye nemcsak az, hogy már ismerik a működését, hanem az is, hogy teljesen platformfüggetlenek.

A Microsoft külön utat jár

A Microsoft a GPU-k mellett már néhány éve egy alternatív csiptípussal, a bármilyen feladathoz hozzáigazítható FPGA (a felhasználás helyén programozható logikai kapumátrix) csipekkel próbálkozik. Már ez is tízszer gyorsabban végezte el ugyanazt, mint az akkori GPU-k, viszont macerás, mert mindig előre be kell programozni a csipeket, hogy el lehessen végezni velük a munkát. A Microsoft FPGA-nagyhatalom, a cég szerint már most is övék a világ legnagyobb ilyen csiprendszere.

Augusztusban bejelentették, hogy Project Brainwave néven új FPGA-csipet fejlesztenek. Ezt ugyanúgy az Intel által felvásárolt Altera fogja gyártani, mint az eddig használt csipjüket. A Google-höz hasonlóan a saját adatközpontjainak a versenyképességét akarja növelni vele a cég, bár egyelőre csak saját belső használatra vezették be, ahogy eleinte a Google is.

A Microsoft a rugalmasság miatt megy ebbe az irányba, a GPU-nál általános megoldást akarnak. Cserébe teljesítményben elmaradtak a dedikált csipektől, de a cég szerint az általuk végrehajtott módosítások most ezen is segíteni fognak. Ez a csip viszont továbbra se alkalmas tréningezéshez, csak a végrehajtáshoz, amit a cég “valós idejű MI”-nek hív, bár ezzel sok újat nem mondanak el róla. A Google-éval ellentétben többféle mélytanulásos keretrendszert is támogatni fog, például a saját CNTK-t, a Google Tensorflowját vagy a Facebook Caffe2-jét.

A cég viszont egy hónappal korábban, július végén is bejelentett egy saját MI-csipet, ami a Hololens nevű kevert valóságos szemüvegük új verziójában fog bemutatkozni. A cég szerint erre azért van szükség, mert semmilyen, a piacon elérhető csip nem elég energiahatékony ahhoz, hogy meghajtsa az akkuval működő kütyüt. A cél, hogy a szemüveg a felhő használata nélkül, helyben tudja elemezni az adatokat, így gyorsabb lesz és mobilabb, mert nem kell mindig online lennie. Főleg képfeldolgozásos és szövegértéses feladatokkal kell majd megbirkóznia.

Az Intel ebben is első akar lenni

A hagyományosan a csippiac éllovasának számító Intel eléggé lemaradt az MI-versenyben. A cég felvásárlásokkal próbál visszakapaszkodni az élvonalba, ezekkel viszont rögtön két vasat is a tűzben tart egyszerre. A Microsoft csipjeit is gyártó Alterát még 2015-ben vették meg 17 milliárd dollárért, és nagy terveik vannak vele: az Intel szerint 2020-ra az adatközpontokban futó csipek harmada ilyen FPGA-csip lesz.

2016 augusztusában pedig több mint 400 millió dollárért vásárolták fel a Nervanát, és még novemberben be is jelentették az első MI-csipjüket a Nervana technológiájára építve, Lake Crest kódnéven. Ezt 2017 végén tervezik piacra dobni, és a Google új csipjéhez hasonlóan a az algoritmusok tréningezésére és végrehajtására is alkalmas lesz.

A lemaradással együtt is több nagy helyzeti előnye van egyébként a cégnek, amelyek segíthetnek neki a gépi tanulás terén is az élre lőni. Egyrészt a hagyományos processzorokkal egyszer már felpörgettek egy egész iparágat, tehát tudják, hogy működik az ilyesmi. Másrészt ebből adódóan adott az infrastruktúrájuk a csipek tömeggyártásához és az értékesítési hálózatuk is ahhoz, hogy mindenhova eljuttassák ezeket. Az látszik, hogy komolyan gondolják, idén márciusban külön csoportot is szerveztek cégen belül az MI-fejlesztéseknek.

Aki él és mozog, az MI-csipet akar gyártani

Nemcsak a három óriás aktivizálta magát, hanem gyakorlatilag mindegyik techcég, amelyiknek valamilyen komolyabb köze van a csipgyártáshoz, na meg egy csokor olyan startup is, amelyiknek még semmi köze hozzá, de nagyon szeretné, ha lenne:

- A GPU-piac harmadik ismert szereplője, az AMD június végén adta ki a Vega nevű új GPU-sorozatuk első modelljét, ennek a hátán terveznek visszakapaszkodni a csipgyártás élvonalába.

- Az IBM már jó ideje dolgozik a TrueNorth kódnevű MI-csipjén, de még mindig jó pár évre van az éles bevetéstől, és sokan szkeptikusan figyelik a fejlesztését.

- A szeptember közepén bemutatott iPhone 8, 8 Plus és X mobilokkal az Apple is beszállt a versenybe: az A11 Bionic nevű vadiúj, saját fejlesztésű csipjükbe bekerült egy Neural Engine nevű neurális processzor is, kifejezetten az olyan MI-feladatok elvégzésére, mint a Face ID arcfelismerése, az Animoji nevű – a felhasználó arcmozgásához igazítható – emojik és hasonlók.

- saját MI-csipen dolgozik, amely Apple Neural Engine munkanéven fut, és az arc- és beszédfelismerésben segítené Sirit, amely a megjelenésekor még forradalmi megoldás volt, de mára jócskán lemaradt a Google Asszisztens és az Amazon Alexa mögött.

- A szinte minden mobileszköz csipjeinek alapját tervező ARM májusban jelentette be a Cortex-A75 és A55 nevű CPU-kat és a Mali-G72 nevű GPU-t. Ezek az első mobilos csipek, amelyek kifejezetten arra készültek, hogy a telefon helyben is meg tudjon birkózni a gépi tanulásos feladatokkal.

- A Huawei szeptember elején mutatta be az új Kirin 970 csipjét, amelyben a CPU és a GPU mellett egy saját fejlesztésű, dedikált neurális processzor (NPU) is helyet kapott.

- A Qualcomm kiadott egy Neural Processing Engine nevű szoftverfejlesztő csomagot, amellyel a külső fejlesztők a már meglévő, hagyományos csipekhez optimalizálhatják az MI-feladatokat az appjaikban. A Facebook már be is építette a szelfiknél használható kiterjesztett valóságos filtereibe.

- A legismertebb újonc a brit Graphcore, amely júliusban rántott be egy 30 millió dolláros tőkeadagot neves támogatóktól. A Groq nevű startupot meg volt Google-ös fejlesztők alapították. És a sor folytatható a Wave Computingtól a Mythicen át a Cerebrasig, amelyet a nyáron 860 millió dollárra értékeltek, ami egészen szép ahhoz képest, hogy még nincsen ismert terméke.

- Még egy magyar cég, az AIMOTIVE is MI-specifikus csipen dolgozik, ez az aiWare nevű technológiájukon alapul, és a Microsoft által is használt csiptípusra, az FPGA-ra épül.

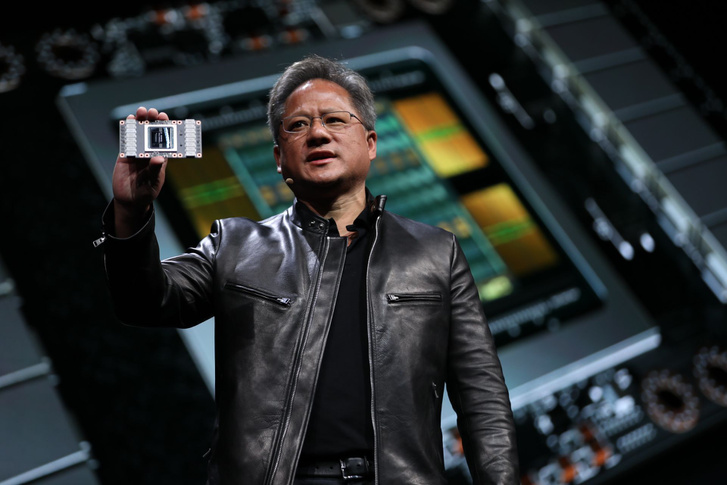

Az Nvidia se hagyja magát

Mindeközben persze az Nvidia se tétlenkedik. Májusban ők is előálltak egy új csippel, a Tesla V100 nevű grafikus processzorral. Ez az első GPU a Volta nevű architektúrával, amelyet kifejezetten a gépi tanulásra hangolt az Nvidia. Nem az egyéni felhasználóknak, hanem nagy adatközpontokba szánják, ahol rengeteg adaton lehet edzeni az algoritmusokat és hasznos trendeket kinyerni a bigdata-elemzésekből.

A V100 fő újdonsága, hogy a hagyományos processzormagok mellett 640 Tensor mag is került bele. Ezeket kifejezetten a mélytanulásban használt műveletek futtatásához tervezték, más a cég szerint 120 teraflopsos teljesítményre képesek az ilyen feladatokban, ami ötször gyorsabb, mint amit a saját előző generációs csipjük tudott, és az első GPU, amely átlépi a 100 teraflopsos teljesítményt a mélytanulásban. Az Nvidia szerint ezzel a korábban hetekig tartó mélytanulásos feladatok pár nap alatt elvégezhetők.

Jensen Huang Nvidia-vezér szerint a v100 bevetésével az adatközpontok teljesítménye akár 15 százalékkal felpörgethető. A vetélytársak erre azt mondják, hogy ez szép, de még ennél is sokkal gyorsabban és hatékonyabban lehetne futtatni a mélytanuló algoritmusokat, ha kifejezetten erre a feladatra terveznek új csipeket, nem egy mellesleg ehhez is használható csipet próbálnak hozzáidomítani. Erre meg az Nvidia mondja azt, hogy mindez jól hangzik, csakhogy ezek az alternatívák mind gyengébbek ilyen-olyan okból: vagy nem elég általánosan bevethetők, vagy túl nagy energiaigényűek. Hogy kinek lesz igaza, most még nem látszik, de az biztos, hogy aki be tud törni erre az egyre fontosabb piacra, az kulcsszerepet játszhat az elkövetkező évek nagy MI-fejlesztéseiben, és a világ megváltoztatása közben szépen meg is szedi majd magát.

Az oldalról ajánljuk

- Külföld

Szijjártó Péter szerint nem lehet komolyan beszélni Ukrajna uniós tagságáról

Donald Trumpról is elmondta a véleményét a külügyminiszter.

február 17., 08:31

- Futball

Rasszizmus miatt szakadt félbe egy meccs a világ egyik legerősebb futballbajnokságában

Ez már a sokadik ilyen jellegű botrány az országban.

február 17., 08:14

- Gazdaság

Új adatokat publikált az Energiaügyi Minisztérium a napelemek számáról

Többségük családi házak tetején működik.

február 17., 08:52

- Belföld

Magyar Péter bement az ATV-be, és elmondta, mivel kéne foglalkoznia a magyar sajtónak

A Tisza elnöke szerint Hadházy Ákos alantas.

február 17., 08:26

- Külföld

Washington kihagyná Európát az ukrajnai megoldásból, Emmanuel Macron riadót fújt

A francia elnök hét európai vezetőt hívott hétfőre Párizsba.

február 17., 09:00

- Külföld

Az AfD társelnöke szerint Ukrajnát nem szabad fegyverekkel és katonákkal támogatni

A másik három kancellárjelölt határozottan nem értett egyet a kijelentéssel.

február 17., 08:16

- FOMO

Shakira kórházba került, a sürgősségire kellett vinni

A világ körüli turnéján történt meg a baj.

február 17., 08:48

- Külföld

Megkezdődhetnek a béketárgyalások Szaúd-Arábiában, megérkezett Marco Rubio

Az orosz fél nem közölte, kiket delegál az egyeztetésekre.

február 17., 08:31

- Futball

Robbie Keane segítője a Fradi veresége után: Lehet, olyan elvárásaink vannak, amiket a játékosok nem tudnak teljesíteni

A zöld-fehérek immáron négy mérkőzés óta nyeretlenek az NB I-ben.

február 17., 09:32

- Vélemény

Magyar Péter és az ellenzéki sajtó viszonya bántalmazó kapcsolat

Ha a NER-t leváltani kívánó ellenzék végül a NER-ből választ egy NER módra működő figurát, abból nem tud más kijönni, csak a NER. Németh Róbert írása.

február 17., 07:31

- Tech-Tudomány

Megvennék az Intel chipgyártását

A szebb időket látott vállalat a hatvanas évek végén kezdte a félvezetőgyártást.

február 17., 09:37

- Külföld

Jön az AfD: Elon Musk hátszelet adott, Orbán Viktor ajtót nyitott, J. D. Vance tabut döntött

Miközben Angela Merkel politikai öröksége egyre csak rozsdásodik.

február 17., 09:05

- Tech-Tudomány

A stressz vezethet az Alzheimer-kórhoz?

Egy új elmélet egyesíti, amit eddig a betegségről tudunk.

február 17., 09:35

- Belföld

Reagáltak az érdekképviseletek Magyar Péter ígéreteire, van még mit csiszolni a terveken

A PDSZ-nek tetszik a Tisza Párt oktatási programja.

február 17., 06:06

- Külföld

Dél-Korea betiltotta a Deepseek használatát

Más ország is hozott már hasonló döntést.

február 17., 08:11

- Téli sport

Sérülése után kórházba került az Európa-bajnok magyar sportoló

A további vizsgálatokat Magyarországon végzik el.

február 17., 07:39

- FOMO

A vajdasági gyilkos, akitől rettegnek a spanyol börtönőrök

Olyan különleges módon bánnak vele, mint senki mással az országban.

február 17., 06:03

- Tudomány

Vadonatúj felfedezés látott napvilágot a madarak kialakulásáról

Olyasmit találtak a kínai tudósok, ami átírhatja az evolúció történetét.

február 17., 07:08

- Sport

Megnevezte Ronaldo a legrosszabb játékost, akivel valaha játszott pályafutása alatt

Volt a Real Madridnál egy játékos, aki egy vicc volt.

február 17., 06:10

- Belföld

Kemény fagyokkal indul a hét, de így is megjelenik a napsütés

A legmagasabb nappali hőmérsékelt 2-3 fok körül alakul.

február 17., 06:10

- Belföld

Orbán Viktor Budapesten fogadja a szerb elnököt

Alekszandar Vucsics egy kitüntetést is átvesz Sulyok Tamástól a magyar fővárosban.

február 17., 07:19

- Degusztátor

Elnémult a kritikus, mert kakaópor került a kacsamájba, a marhaszívet meg füstre tették

Pierre a Costes Downtown étteremben járt.

február 17., 06:37

- Futball

Neymar legutóbb tizenkét éve tett ilyet

Gól, gólpassz és Messit idéző performance.

február 17., 06:42

- Külföld

Halálos áradás Kentuckyban, a Nemzeti Gárdát is bevetették

Egy hétéves gyerek is életét vesztette.

február 17., 06:09

- Futball

Előkotorta a katalán lakájmédia a 16 évvel ezelőtti Real Madrid–Osasuna-meccset

„A televíziót feldughatjátok a s.ggetekbe!”

február 17., 06:49

- Külföld

Őrült, vagy csak provokál Trump, vagy tényleg átszabja Amerika külpolitikáját?

Megnyilvánulásait figyelve sokan felteszik ezt a kérdést.

február 17., 07:15

- Külföld

Megszúrtak egy férfit a berlini holokauszt-emlékműnél, hajtóvadászat indult

Az áldozat súlyos sérüléseket szenvedett.

tegnap, 21:31

- Belföld

Több kilométeres torlódás alakult ki az M0-s autóúton egy baleset miatt

Az M7-es autópályán is baleset történt.

február 17., 08:19

- Kultúr

A brit filmakadémiánál is díjat kapott A brutalista, Ralph Fiennes filmjét is elismerték

február 17., 06:09