Lenyomja a Google mesterséges intelligenciája a Starcraft II-játékosokat is?

További Godmode cikkek

A Google 2014-ben megvette magának pár százmillió dollárért a DeepMind nevű, mesterséges intelligenciával foglalkozó céget, majd a Google AlphaGo megalázóan simán legyőzte Li Szedol govilágbajnokot. Most még nagyobb kihívás elé szeretnék állítani a mesterséges intelligenciát, ugyanis a Starcraft II-re eresztik rá, írja a The Verge.

Lassan eljön a Skynet

Demis Hassabis egy amolyan programozó csodagyerek, kedvence területei a kognitív idegtudományok és a mesterséges intelligencia. Ő alapította 2011-ben MI-startupként a DeepMindot, amit 2014 januárjában a Google megvett 400 millió dollárért. Hassabis eközben elkezdett kutatni és több publikációja is megjelent, egyik legérdekesebb területe a deep reinforcement learning, ami egyesít két gépi tanulási módszert: a megerősítéses tanulást és a mélytanulást.

A mélytanulás annyit jelent, hogy különféle típusú adatokat több rétegben, több szinten is feldolgoznak (pl. gerinces->emlős->macska), a megerősítéses tanulás pedig kicsit olyan, mint az embernél a tapasztalati úton való tanulás. A gép megpróbál megoldani egy feladatot, de ha elbukik közben, akkor a következő nekifutásra már mással próbálkozik, egészen addig, míg sikeresen végre nem hajtja. Ekkor megjegyzi, hogy mit csinált jól, egyre ügyesebbé és ügyesebbé válva.

Hassabis és csapata ezt a két tanulási folyamatot felhasználva létrehozott egy olyan algoritmust, ami idővel bizonyos régi Atari-játékokon sokkal jobban teljesített, mint amire ember valaha is képes volt. Ráadásul úgy, hogy az algoritmusba előzőleg semmit nem tápláltak be és pont ugyanannyi adattal rendelkezett, mint amennyivel egy ember rendelkezhet: azzal, amit a játékos a képernyőn lát.

A híres gopárbaj

A sakk vagy a go kifejezetten alkalmas a mesterséges intelligencia tanulékonyságának a tesztelésére, hiszen a játékos és az algoritmus is ugyanazt látja. Számítógép ennek következtében kvázi fair módon győzte már le az embert sakkban és más hasonló játékban. 1997-ben például az IBM akkori szuperszámítógépe, a Deep Blue 2-1-re megverte Gari Kaszparovot is. Arra viszont soha nem volt ez idáig példa, hogy egy számítógép legyőzzön egy jobb gojátékost.

A go szabályai olyan elegánsak, természetesek és szigorúan logikusak, hogy ha léteznek intelligens életformák bárhol máshol az univerzumban, szinte biztos, hogy játszanak gót

-mondta anno Edward Lasker, huszadik századi go- és sakkjátékos.

A go egy ősi kínai játék, ami alapvetően pofonegyszerű. Van egy 19×19 vonalból álló pálya és két játékos, akik felváltva tesznek fel fekete és fehér köveket, a cél pedig, hogy minél nagyobb területet szerezzenek. Ez eddig a mesterséges intelligencia fejlesztőknek hatalmas kihívást jelentett, ugyanis olyan szintű intuícióra és helyzetfelismerésre volt szükség, amivel a gépek nem tudtak mit kezdeni. Egészen 2014-ig, amikor is a Google AlphaGo-ja simán legyőzte a regnáló govilágbajnokot, Li Szedolt 4-1-re. Ez annyira felbuzdította a fejlesztőket, hogy komolyabb kihíváson kezdtek el gondolkodni.

Következő lépés: a Starcraft II

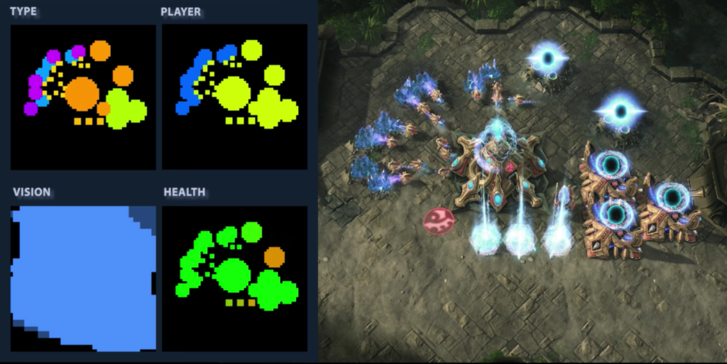

A Starcraft II egy valós idejű stratégiai játék, amiben a sikerhez fel kell deríteni a környéket , gazdálkodni kell és nem árt pár jó harci taktika sem. Ezáltal az egyik legösszetettebb és legbonyolultabb videojáték a világon. A góhoz képest a felderítés jelenti a legnagyobb nehézséget, hiszen míg a kínai játéknál a játékos (és az algoritmus) látta az egész pályát és tudott az alapján tervezni, itt nincs meg ez az előny. Épp ezért ideális terep a DeepMind további kutatásaihoz.

A játékot készítő Blizzard Entertainment és DeepMind közös projektje az, hogy a játékot úgy módosítsák a 2017-es év első negyedében, hogy az megfeleljen a mesterséges intelligencia kutatási környezetének. Ez ugyanis jelenleg nem így van, Starcraft II-ben futó mesterséges intelligencia teljesen más elvek szerint működik, mint a DeppMindé. Előbbit kézzel tervezték úgy, hogy különböző nehézségi szinteket okozzon, ráadásul képes arra, hogy úgy irányítson harci egységeket a játékban, hogy azok a képernyőn nem is látszanak. A cél viszont az, hogy olyan mesterséges intelligenciát hozzanak létre, ami nemcsak, hogy jobban játszik az embernél, de ugyanolyan korlátok vonatkozzanak rá.

Ehhez lehetőséget biztosítanak minden mesterségesintelligencia-kutatónak, hogy ha akar, részt vehessen a munkában. Leegyszerűsítik a játék grafikáját, hogy könnyebben be lehessen táplálni a gépi tanulási rendszereket, valamint a Blizzard kiad Starcraft II-visszajátszásokat, amikből a mesterséges intelligencia tanulhat. Ugyanakkor a fejlesztők szerint még jó ideig várni kell, hogy a mesterséges intelligencia legyőzze a legjobb játékosokat, de ha eljön az a nap, akkor hatalmasat fog szólni.

Rovataink a Facebookon