Elindult az Indamedia média és marketing-kommunikációs kiadványa.

További szakmai tartalmakért kattints és kövess bennünket!

MEGNÉZEM

Kamuprofilok, terrorista propaganda, bullying és zaklatás.

Az ismert adatvédelmi problémák mellett ezek a Facebook kritikusai által leggyakrabban emlegetett rákfenék – nem csoda, hogy a cég a londoni irodájában tartott sajtóeseményén is az ezek elleni harcba igyekezett betekintést nyújtani a meghívott újságíróknak. A Facebook nagy erőkkel kommunikálja, hogy bár valóban komoly problémákról van szó, mindent megtesznek azért, hogy visszaszorítsák ezeket a káros jelenségeket, és ebben komoly sikereket is fel tudnak mutatni. Szintén gyakori kritika az átláthatóság hiánya, úgyhogy a transzparencia jegyében maguk a cég mérnökei meséltek arról, hogyan lépnek fel a visszásságok ellen.

A káros tartalmak elleni védelem nagy vonalakban három egységből épül fel: a tartalmi irányelvekért felelős csapat dolgozza ki a közösségi sztenderdeket; az ezeket megsértő tartalmakat aztán egyrészt egy emberi ellenőrzést végző csapat hivatott biztosítani; másrészt folyamatosan fejlesztik azokat a technológiákat, amelyek képesek lehetnek az ép ésszel befogadhatatlan mennyiségű tartalom szűrésérésre, illetve az előválogatásukra az emberi ellenőrök – gyakran nem éppen álomszerű – munkájának a segítéséhez – ez utóbbit világszerte több csapat is végzi, de épp Londonban található közülük a legnagyobb.

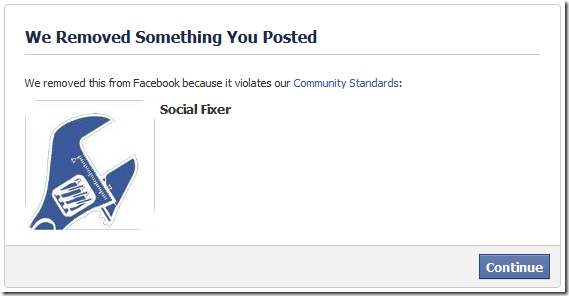

Ahogy maguk a problémák is sokfélék – álhírek, terrorista propaganda, meztelenség, zaklatás, gyerekek kihasználása, pénzügyi átverések, stb –, úgy az ezek ellen bevetett eszközök is változatosak. Ezt persze nem úgy kell elképzelni, hogy egy tartalom vagy problémás, ezért leszedik, vagy nem az, így maradhat. Egyrészt a probléma – és a céggel szembeni kritikák – gyökere éppen az, hogy sok esetben ennél jóval kevésbé egyértelmű, hogy valamit el kéne-e távolítani. Másrészt ha döntés születik egy-egy bejegyzésről, az még nem feltétlenül jelenti a történet végét, ezután még kiderülhet, hogy a döntés hibás volt. Ezt a Facebook is elismeri, bár ők inkább azt hangsúlyozzák ebből, hogy annyi a bizonytalan tényező – kulturális különbségek, társadalmi megítélésbeli változásokat, törvénymódosítások, stb –, hogy a rendszer jellegéből adódóan sosem lehet tökéletes, mindig fognak hibázni valamennyit, a kérdés csak az, hogy mennyit. Épp ezért tartják a rendszer kulcsfontosságú részének a folyamatos felhasználói visszajelzést.

A folyamat nagyjából így néz ki, persze jól leegyszerűsítve:

A Facebook szerint minden hibájával együtt ez a folyamat egészen hatékony, a cég kritikusai szerint viszont még így is követhetetlen mennyiségben termelődik a felhasználók mindennapjait megkeserítő káros tartalom. Annyi biztos, hogy elképesztő számú ilyen tartalmat távolítanak el az oldalról, persze ezeket a számokat rögtön árnyalja is, hogy a Facebook esetében olyan léptékről beszélünk, hogy még ha millió számra irtják is a gyomot, akkor is annyi gaz marad hátra, hogy minden egyes felhasználónak kijönne belőle egy tekintélyes méretű csokor.

A legtöbbet spamből távolítanak el, ebből csak idén július és szeptember között töröltek 1,9 milliárdot. Szoros másodikak a kamuprofilok, ezekből 1,7 milliárd ment a kukába. Itt aztán jön egy óriási szakadék a statisztikában: a dobogó harmadik helyén álló meztelenség és szexualitás témakörében eltávolított posztok száma már csak 30,3 millió, majd ebben a nagyságrendben jön sorban a többi: erőszak – 25,2 millió, gyerekek szexuális kizsákmányolása – 11,6 millió, gyűlöletbeszéd – 7 millió, terrorista propaganda – 5,2 millió, drogok – 4,4 millió, bullying és zaklatás – 3,2 millió, öngyilkosság – 2,5 millió, illetve fegyverhasználat – 2,3 millió.

A Facebook célja, hogy minél több problémás tartalom már azelőtt eltűnjön az oldalról, hogy egyáltalán a felhasználók szeme elé kerülhetne.

Ebben a proaktív fellépésben van nagy szerepe a gépi tanulásra épülő rendszernek, amely tetszőlegesen bővíthető, így bármilyen embertelen mennyiségű tartalom pillanatok alatt átfésülhető vele. A technológia fejlődésével egyre nagyobb az ilyen csírájukban elfojtott próbálkozások aránya, például az eltávolított spamek 99,9, a kamuprofilok 99,7 százalékát már azelőtt törlik, hogy bárki jelentené. Ebből a trendből két terület lóg ki látványosan: a gyűlöletbeszédnek csak 80,2 százalékát sikerül proaktívan eltüntetni, a bullyingnak és zaklatásnak pedig csak a 16,1 százalékát tudják előre kiszűrni. A Facebook mérnökei szerint ennek az az oka, hogy ezek sokkal inkább kontextus-, azaz kultúra-, ország- és nyelvfüggők, így jóval nehezebb dolguk van velük. A bullying még nehezebben megfogható, mert akár egyénenként is változó, mit számít zaklatásnak, ki mit ítél bántónak, egy-egy társaságban mi választja el az ártalmatlan viccelődést a valóban káros megnyilvánulásoktól. Ezekben az esetekben gyakran csak az áldozat tudja, hogy áldozat, ezért csak az ő jelzésére lehet fellépni az őt érintő káros tartalom ellen.

A technológia folyamatosan fejlődik, de a Facebook szerint a legnehezebb feladat az egyensúly megtalálása. Ha azt akarják, hogy minél több problémás tartalom akadjon fenn a szűrőn, csavarhatnak egy kiadósat az algoritmusok szigorán, de akkor félő, hogy megszaporodik a fals pozitív találatok száma is, azaz túl sok olyan tartalom esik a szigor áldozatául, amelyekkel valójában semmi gond sincs – elég csak a meztelenség miatt törölt festmények, ikonikus fotók és kőszobrok nagy felbolydulást kiváltott eseteire gondolni. Ha viszont lazítanak a gyeplőn, hogy elkerüljék az ilyen melléfogásokat, óhatatlanul több valóban problémás bejegyzés csúszhat át a szűrőn. Utóbbira ártalmatlan, de szemléletes példát szolgáltatott egy indexes kolléga, akinek a Facebook tévedésből letiltotta egy strandoló gyerekről készített fotóját, mert meztelenkedésnek ítélte. Amikor azonban ugyanazt a fotót digitálisan ellátta egy ormótlan aranykerettel, már simán átcsúszott a szűrőn – feltehetően azért, mert a Facebook engedékenyebbé vált a műalkotásnak tűnő tartalommal szemben.

A kamuprofilok kérdése különösen kényes a Facebooknak, nemcsak a nagy számuk miatt, hanem azért is, mert ezek jelentik sok további visszaélés – álhírek, spamek, átverések – melegágyát is.

A Facebook alapvetően kétféle kamuprofilt különböztet meg. Vannak olyanok, amelyeket bármiféle ártó szándék nélkül, gyakran véletlenül hoznak létre; ilyenek a háziállatok vagy fiktív karakterek profiljai, illetve a cégek fiókjai, amelyeknek valójában nem felhasználói profilt, hanem úgynevezett oldalt kellett volna létrehozni. Ilyenkor általában elég szólni az illetőnek, és a probléma magától meg is oldódik. Sokkal érdekesebb persze a másik kategória, amelybe a köznyelvi értelemben vett kamuprofilok tartoznak, vagyis azok, amelyekkel tudatos szabálysértés a létrehozók szándéka.

Utóbbiak ellen három fázisban lépnek fel. Egyrészt több millió próbálkozást még azelőtt blokkolnak, hogy egyáltalán létrejöhetne a kamuprofil, például olyan IP-címek blokkolásával, ahonnan gyanús tevékenységet észlelnek. A második szintet elérő esetekben a kamuprofilt sikerül létrehozni, de még mielőtt bármiféle aktivitást produkálhatna, lekapcsolják. A harmadik csoport azoké a kamuprofiloké, amelyeknek sikerül meglógni a törlés elől.

A Facebook folyamatosan irtja a kamuprofilokat, november közepén például bejelentették, hogy idén már 5,4 milliárdot gyomláltak ki, ami jelentős növekedés ahhoz képest, hogy 2018-ban a teljes évben távolítottak el 3,3 milliárdot. A számok egyébként néhány hónapon belül is gyakran ingadoznak, de ez nem feltétlenül jelenti azt, hogy ennyivel ügyesebb vagy ügyetlenebb volt éppen a cég. Sokkal inkább azzal van összefüggésben, hogy hullámzó a kamuprofil-gyárosok aktivitása is, van, hogy egy-egy nagy rohamot indítanak, aztán amikor ez kifárad, új módszer után néznek, és ilyenkor csökken a próbálkozások száma.

Örök vita folyik arról, hogy valójában mennyi lehet az aktív kamuprofilok száma az oldalon. A Facebook saját friss becslése szerint az aktív profilok 5 százakéka lehet kamu, de külső szakértők és a cég kritikusai ennél rendre nagyobb számokat, akár 20 százalékos arányt emlegetnek. Bochra Gharbaoui, a Facebook adattudósa az ezzel kapcsolatos kérdésünkre azt mondta, ez az eltérés abból adódik, hogy a független számítások összekevernek különböző számokat. A Facebook például a létrehozás előtt megakadályozott próbálkozásokat egyáltalán nem tartja számon, az eltávolított kamuprofilok statisztikáiban csak a második és a harmadik kategória profiljai szerepelnek. A bűvös 5 százalék pedig csak az aktív kamuprofilokra vonatkozik, mert ezeket tartják a gyakorlatban is ártalmasnak, míg mások hajlamosak a köztes kategóriát, azaz a regisztrált, de nem aktív profilokat is beszámítani, akárcsak azokat a profilokat, amelyek nem kamuk, csak helytelenül profilként hozták létre őket, illetve azokat is, amelyek egyszerű duplikátumok, mert valaki például elfelejtette a jelszavát az első profiljához, és újraregisztrált. Bárkinek is van igaza, érdemes megjegyezni, hogy az 5 százalék ugyan elsőre nem tűnik soknak, de ha beszorozzuk a bő 2,4 milliárdos havi aktív felhasználói számmal, azért még így is azt kapjuk, hogy

a Facebookon a folyamatos takarítás ellenére átlagosan 120 millió kamuprofil él és virul.

Arról is kérdeztük Gharbaouit, hogy ha ilyen nagy problémát jelentenek a kamuprofilok és ilyen nehéz ellenük fellépni, miért nem szigorítanak magán a regisztrációs folyamaton, mondjuk extra azonosítás kérésével, hogy tényleg csak valódi emberek tudjanak csatlakozni a a saját nevükben. Gharbaoui szerint ez elvben jól hangzik, de a gyakorlat azt mutatja, hogy sokaknak az is gondot jelent, hogy az emailcímüket igazolják, és bármiféle szigorítás azt jelentené, hogy a felhasználói bázis nagy részét adó fejlődő országbeli emberek közül sokakat kizárnának a platformról, amit semmiképpen nem szeretnének. Nem akarnak elfogultak lenni bizonyos régiók vagy demográfiai csoportok irányába, a regisztrációs folyamat földrajzi alapú differenciálása – azaz hogy például egy amerikai fiatalt nagyobb szigorral kezeljenek, mind egy szudáni nagymamát – pedig nem életszerű, mert a földrajzi korlátozások könnyen kikerülhetők, ami visszaélési lehetőséget jelentene a profilgyárosoknak.

Ha már Gharbaouival külön is volt lehetőségünk beszélgetni, arról is kérdeztük, milyen kutatóként egy olyan cégnél dolgozni, amelyet más kutatók rendszeresen és erősen kritizálnak. Azt mondta, ez kicsit elszomorítja, de megérti, mert a kritikák forrása szerint általában az, hogy a Facebookon kívüli kollégái nem ismerik a teljes kontextust, nincsenek azoknak a belső információknak a birtokában, amelyeknek ő igen. Ezért próbálnak szorosabb kapcsolatot kiépíteni a kutatói közösséggel, sőt nemcsak velük, hanem az átlagfelhasználókkal is, hogy jobban el tudják magyarázni a színfalak mögötti folyamatokat. Gharbaoui szerint gyakran előfordul, hogy sikerül is meggyőznie más kutatókat.

Hogy a közbizalmat sikerül-e visszaszereznie a Facebooknak, az más kérdés. Persze amíg a pénzügyi eredményeikben nem kezdenek el nyomot hagyni az adatvédelmi botrányok és más visszás ügyek, addig a cég szempontjából a válasz talán nem is olyan nagyon fontos.

Munkatársunk a Facebook meghívására és költségén vett részt a rendezvényen. A cikk enélkül nem készülhetett volna el, ugyanakkor teljes egészében szerkesztőségi tartalom, készítésére a cég semmilyen befolyással nem volt.(Borítókép: Facebook moderátorok irodája a Texas állambeli Austinban. Fotó: The Washington Post / Getty Images Hungary)

Elindult az Indamedia média és marketing-kommunikációs kiadványa.

További szakmai tartalmakért kattints és kövess bennünket!

MEGNÉZEM